Un nuevo trabajo liderado por el Instituto Galego de Física de Altas Enerxías (IGFAE) propone una novedosa estrategia, basada en computación cuántica, para simular procesos físicos en el Gran Colisionador de Hadrones (LHC)

El Modelo Estándar (SM) de Física de Partículas es la teoría más exitosa y aceptada para describir las partículas elementales que componen el universo y la forma en la que interaccionan a través de la fuerza nuclear fuerte, débil y electromagnética. En el lenguaje del Modelo Estándar, la naturaleza se describe en términos de campos fundamentales que se extienden por el universo. Un campo puede entenderse como la distribución de la temperatura dentro de una habitación ‒el Universo‒, con lugares donde ésta es muy alta o baja, que corresponden en el SM a puntos del Universo donde se encuentra una partícula. Este modelo ha sido y sigue siendo ampliamente probado en varios experimentos distribuidos por todo el mundo. Quizá el más famoso sea el Gran Colisionador de Hadrones (LHC, por sus siglas en inglés) del CERN, en Ginebra, donde en 2012 se observó por primera vez la última pieza del Modelo Estándar que faltaba por verificar: el bosón de Higgs.

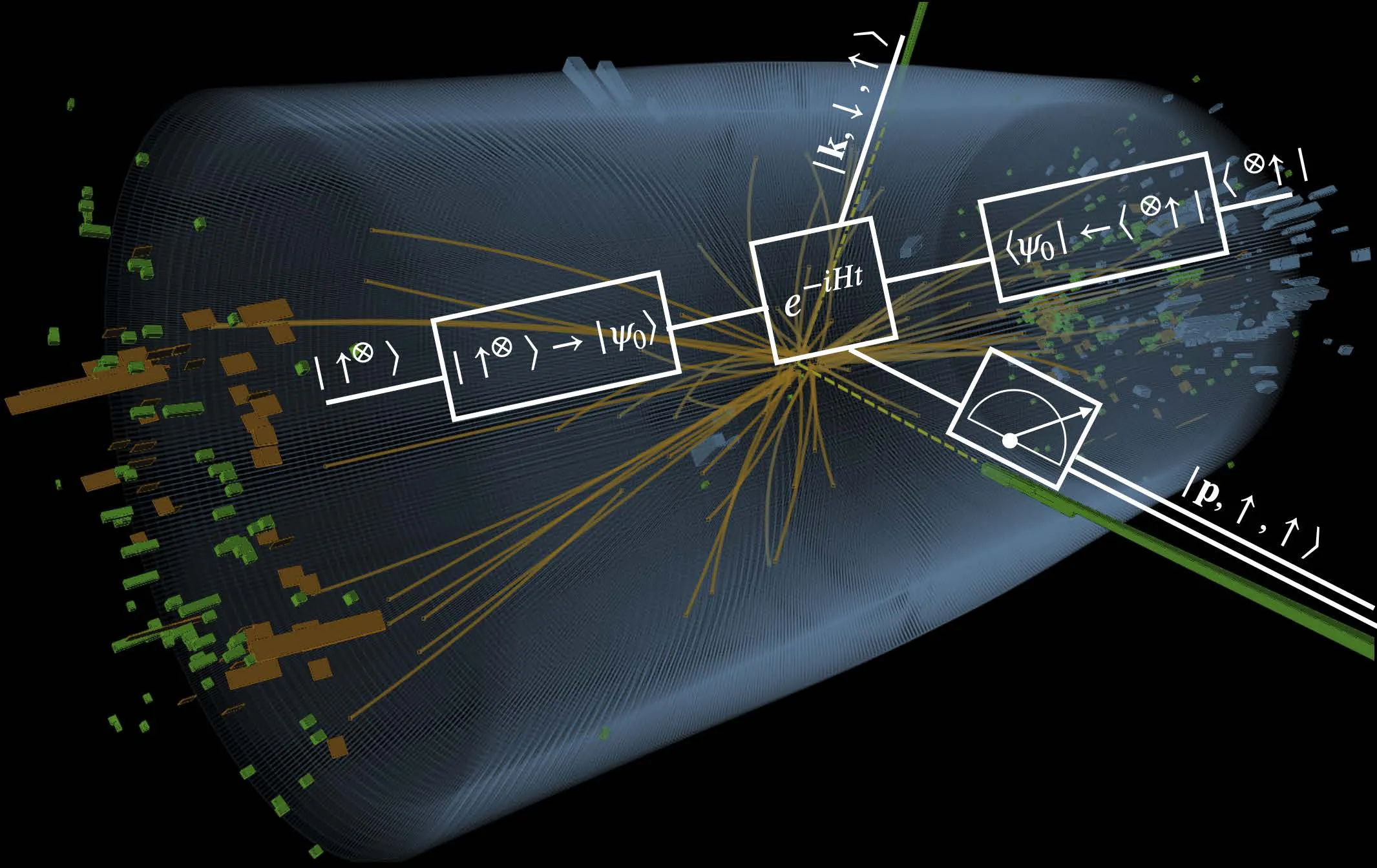

El LHC pone a prueba el SM acelerando protones a una velocidad cercana a la de la luz en un anillo de 27 km para hacerlos chocar después. Dado que los protones están compuestos por otras partículas elementales, se rompen tras colisionar y producen una plétora de estados finales ‒como si golpeásemos bolas de billar a gran velocidad‒ que los detectores del LHC miden y se comparan con simulaciones teóricas. Esta práctica ha sido muy exitosa, pero cuando se aumenta la precisión de los datos experimentales, por ejemplo, para buscar nueva física más allá del Modelo Estándar, las capacidades computacionales de los ordenadores actuales son limitadas.

No obstante, como se señaló por primera vez en el trabajo fundacional de Jordan, Lee y Preskill (JLP), estas dificultades técnicas pueden superarse, en principio, representando los campos asociados a las partículas del Modelo Estándar en términos de bits cuánticos (qubits) y simulando sus interacciones mediante un ordenador cuántico. Aunque este enfoque es, en teoría, exponencialmente más rápido que el mejor algoritmo de simulación clásico conocido, la cantidad de qubits necesarios supera con creces el número previsto que estará disponible en los ordenadores cuánticos a corto plazo, lo que impide su aplicación en los próximos años. Por ello, es muy interesante considerar otros algoritmos cuánticos para simular los procesos del LHC en un futuro próximo.

Ahora, un nuevo estudio publicado recientemente en la revista Physical Review A por el investigador predoctoral del IGFAE João Barata, junto con Niklas Mueller (Universidad de Maryland), Andrey Tarasov (Universidad del Estado de Ohio y Centro para las Fronteras de la Ciencia Nuclear en la Universidad de Stony Brook) y Raju Venugopalan (Laboratorio Nacional de Brookhaven), propone una estrategia novedosa para simular la dispersión de partículas de alta energía, motivada físicamente por el modelo de partones de Feynman. En dicho modelo, cuando los protones colisionan a alta energía, pueden verse como un conjunto de partículas fundamentales menos energéticas. Así, en lugar de describir los campos de los protones en términos de bits cuánticos, es más sencillo asignar directamente las partículas a los grados de libertad disponibles en el ordenador cuántico. Por lo tanto, mientras el número de partículas sea pequeño, se espera que este enfoque sea el natural para describir las colisiones producidas en el LHC.

“Aunque su puesta en práctica requiere todavía más recursos que los disponibles en los ordenadores cuánticos actuales, ofrece en algunos aspectos importantes una ventaja directa sobre la propuesta de JLP para simular la dispersión de alta energía”, explica João Barata, quien está realizando su tesis doctoral en el IGFAE gracias a una beca INPhINIT de la Fundación “la Caixa”. “Por ejemplo, utilizando esta “imagen de partículas”, el cálculo en un ordenador cuántico es notablemente similar a los protocolos de medición utilizados en los detectores del LHC. Además, este algoritmo puede aplicarse directamente a los cálculos teóricos más estándar de los procesos que rigen el Modelo Estándar, por lo que esperamos que pueda encontrar muchas más aplicaciones más allá de este trabajo”.

Las aplicaciones de computación cuántica a análisis de datos experimentales y cálculos teóricos en Física de Altas Energías, Astrofísica y Física Nuclear es un campo emergente en todo el mundo, de crecimiento exponencialmente rápido y con gran interés en el IGFAE, donde investigadores están dirigiendo sus esfuerzos hacia los retos de la segunda revolución cuántica.

Referencias:

J. Barata, N. Mueller, A. Tarasov, R. Venugopalan, Phys.Rev. A, 103 (2021), 042410. doi.org/10.1103/PhysRevA.103.042410

Imagen: Ilustración de una colisión de dos fotones en el experimento CMS del CERN durante la búsqueda del bosón de Higgs en 2011 y 2012. El “circuito” sobreimpreso representa el mismo proceso que se simula en un ordenador cuántico: los recuadros y las líneas son las partes de este circuito (como se tendría en un circuito eléctrico) y las fórmulas representan la operación física que se realiza. Crédito: CERN.